Un équipe de chercheurs planchant sur le deep learning a développé un outil permettant d'améliorer, grâce à la supposition, la résolution des images. Nom du projet : Google Brain.

Vous avez déjà vu cette scène dans toute série policière qui se respecte : dans un labo sombre, les agents tentent d’identifier un homme ou une femme à partir d’images de vidéosurveillance. Problème, celles-ci sont trop floues, et évidemment, l’individu est habillé en noir, avec une casquette pour que l’exercice soit encore plus simple.

Solution : le nerd de la série tapote n’importe quoi sur son clavier en nous faisant croire qu’il "code". Paf, l’image devient nette en quelques secondes, parce que c’est un génie de l’informatique, que voulez-vous. L’inspecteur ne dit évidemment pas merci et généralement, passe la porte du labo dans la foulée sans prendre son manteau.

L’IA va ainsi tenter de "deviner" à quoi une image pourrait ressembler si elle était en meilleure définition

S’en suit le moment où vous lâchez mollement un "genre, n’importe quoi". Et le schéma se répète inlassablement, depuis notre enfance, sans qu’il ne soit toujours possible dans la vraie vie de faire CE TRUC ABSURDE des pixels qui se multiplient miraculeusement.

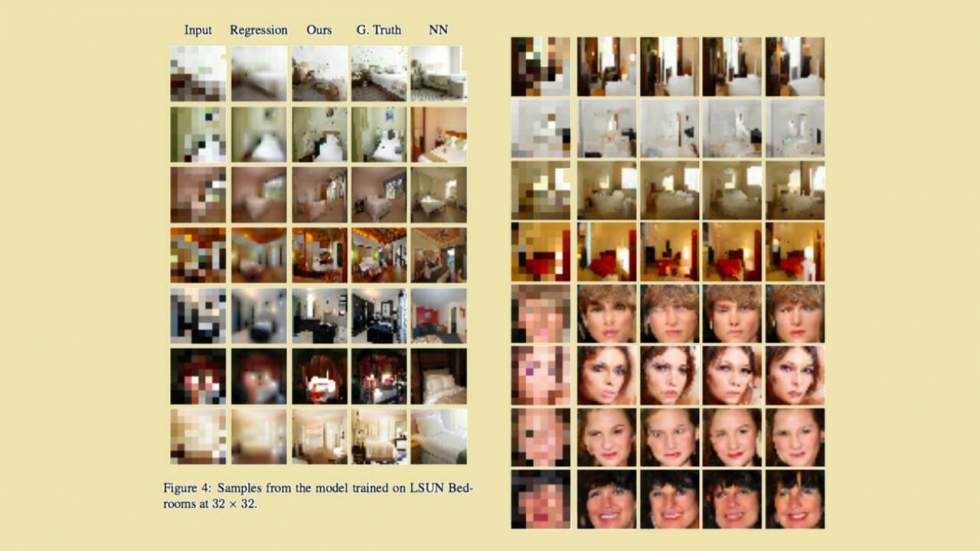

Mmm, attendez. Qui vois-je venir, là, avec son sourire en coin de monsieur je-sais-tout. Google, évidemment. Selon Ars Technica UK, une équipe de chercheurs qui travaille sur la technologie du deep learning a mis au point un logiciel qui "affine" les images floues en 8 x 8 pixels. Évidemment, il ne s’agit pas d’une restauration directe des pixels préexistants d’un visuel, mais plutôt d’un travail de "suggestion" de nouveaux pixels par l’ordinateur. En partant d’une image pauvre en qualité, l’intelligence artificielle va ainsi tenter de "deviner" à quoi celle-ci pourrait ressembler si elle était en meilleure définition.

Deux réseaux neuronaux activés

Le processus, qui s’appuie sur une activation d’un réseau neuronal artificiel, se fait en deux temps. D’abord, l’ordinateur entre dans une phase de "conditionnement" : il mappe son image en 8 x 8 à partir d’autres images en plus haute résolution qu’il estime similaire, sur certains points, à sa source. Il réduit ensuite ces images HD en 8 x 8 pour tenter de déterminer des correspondances.

Dans un second temps, la machine opère une implémentation de PixelCNN pour ajouter des détails réalistes et en HD à l’image source. En bref, après avoir digéré quantité d’images au préalable, elle est capable d’identifier qu’un pixel rose ou rouge vers le bas de l’image correspond à une bouche. Une fois l’image traduite en HD, elle aura ajouté les pixels nécessaires à la création de la fameuse bouche.

Les résultats obtenus lors des deux étapes mélangés, une image finale de plus grande qualité est suggérée. Reste maintenant à savoir si l’on veut bien faire confiance à l’IA de Google, quand on sait que ce qui se cache dans son inconscient...

Quelque chose à ajouter ? Dites-le en commentaire.